Wird menschliches Verhalten durch die Kombination aus intelligenten Algorithmen und dem digitalen Fußabdruck immer berechenbarer? Was sind die Folgen dieser Entwicklung? Diese Fragen standen im Zentrum der Diskussionen beim 9. SURPRISE FACTORS SYMPOSIUM. Drei international renommierte Expert*innen wurden eingeladen, ihre Einsichten mit ACADEMIA SUPERIOR zu teilen, um daraus Ideen und Empfehlungen entwickeln zu können.

Geleitet und moderiert wurden die Diskussionen von der Journalistin Dr. Melinda Crane und dem wissenschaftlichen Leiter der ACADEMIA SUPERIOR, Univ.-Prof. Dr. Markus Hengstschläger. Auch Mitglieder des wissenschaftlichen Beirats und der Young Academia brachten sich rege in die Gespräche ein. „Die technologischen Entwicklungen – wie die These ‘Privacy is gone’ – sind da und wir müssen uns auch mit ihnen auseinandersetzen. Ein Zurückdrehen der Zeit wird nicht möglich sein. Also ist die große Frage: Wie können wir diese neuen Technologien in unsere Gesellschaft integrieren, damit unsere Gesellschaft trotzdem wertschätzend, wohlwollend, offen, kritikfähig und verantwortungsbewusst bleibt“, fasste die designierte Obfrau LH-Stv. Mag. Haberlander das Ziel der Diskussionen zusammen.

Privatsphäre ist eine Illusion

Prof. Michal Kosinski, PhD von der University Stanford zeigte bereits im Jahr 2016 in einem aufsehenerregenden Artikel mit dem Titel „Ich habe nur gezeigt, dass es die Bombe gibt“, dass mit den heutigen Möglichkeiten der Datenanalyse das Verhalten von Menschen nicht nur vorhergesagt, sondern auch beeinflusst werden kann.

Seine provokante These, die Privatsphäre ist ein Auslaufmodell, untermauerte Kosinski mit anschaulichen Zahlen und Fakten: „Wir alle hinterlassen mit unseren Aktivitäten im Internet einen digitalen Fußabdruck – Bereits im Jahr 2012 erzeugte eine Person eine Datenmenge von 500 Megabyte pro Tag. Und laut Prognosen werden es 2025 bereits 62 Gigabyte pro Tag sein.“ Diese Daten stammen aus dem digitalen Fußabdruck durch die Nutzung von Smartphones, Social Media, dem Internet, Sprachassistenten, Überwachungskameras, Sensoren oder Kreditkarten usw., denn alle ‚smarten‘ Geräte zeichnen auch Daten auf.

Facebook kennt uns besser als die Partnerin

In einer Studie mit 60.000 Teilnehmer*innen konnte Kosinskis Team zeigen, dass es nur ca. 250 Likes auf Facebook braucht, damit ein Algorithmus einen Menschen in einem Persönlichkeitstest genauso gut einschätzen kann wie dessen Lebenspartner*in. Dies hat zur Folge, dass durch eine solche Auswertung auch z.B. individuell zugeschnittene Werbung oder Botschaften vermarktet werden können.

Das Bestreben, Privatsphäre umfassend zu schützen, stößt immer mehr an seine Grenzen. „Unternehmen kann man ja vielleicht noch dazu verpflichten, aber kriminelle Organisationen oder Individuen werden immer irgendwie Zugriff auf sensible Daten erhalten und die Bequemlichkeit der Menschen tut ihr übriges“, betonte der Psychologe und Datenforscher aus Stanford und wies darauf hin, dass die große Mehrheit der Menschen Daten freiwillig bereitstellt, um Onlinedienste nutzen zu können, die ihr Leben einfacher und besser machen. Solche Dienste würden ohne diese Daten nicht funktionieren. Die Schlussfolgerung des Experten stimmt nachdenklich, denn man könnte fast behaupten: wer seine Daten nicht freigibt, verhält sich unsozial und profitiert nur davon, dass viele andere es tun.

Doch die Entwicklung hat auch eindeutigere Schattenseiten: In seiner neuesten Studie zeigt Kosinski, dass eine Künstliche Intelligenz nur fünf Profilbilder einer Person benötigt um mit 80–90 prozentiger Sicherheit deren sexuelle Orientierung einordnen zu können. „Ein Umstand, der in unseren liberalen Gesellschaften eher nebensächlich ist, aber in Staaten, in denen Homosexualität unter Todesstrafe steht, bedeutet es eine Frage von Leben und Tod“, so Kosinksi.

Privatsphäre ist eine Illusion. Desto eher man die Realität akzeptiert, desto eher kann man sinnvoll über die notwendige Politik reden. – Michal Kosinski

„Auch ich mache mir Sorgen um den Missbrauch von Daten, aber ich bin überzeugt, dass 99,9 % der Algorithmen positiv genutzt werden, um den Menschen zu helfen. Daher bin ich dafür, dass wir akzeptieren, dass Privatsphäre Vergangenheit ist und wir uns mehr darauf konzentrieren, die Risiken zu minimieren und den Nutzen zu maximieren“, betonte Kosinski und fügte hinzu: „Nur wenn wir diese Realität akzeptieren, können wir über die notwendige Politik diskutieren und das Beste aus der neuen Technologie herausholen”.

Ethische Regeln für Roboter

Roboterforscher und ‑designerin Univ.-Prof. Dr. Nadia Thalmann von der Nanyang Technological University schilderte ihre Erfahrungen mit dem Einsatz von sozialen Robotern. Der technologische Fortschritt macht es möglich, dass Maschinen menschliche Sprache, Gesten und Emotionen aus Bewegungen, Ton und Bild erkennen können, sich an Menschen erinnern, bei Fragen im Internet nach Antworten suchen und sich in mehreren Sprachen unterhalten.

Der von Prof. Thalmann kreierte Roboter Nadine arbeitet derzeit in einem Testversuch im Kundenservice eines Versicherungsunternehmens. Erste Ergebnisse zeigen, dass der Roboter nicht nur schneller auf Anfragen reagiert als die menschlichen Kolleg*innen, sondern auch, dass die Kund*innen den Roboter gut akzeptieren.

Die weitere Zukunft ihrer Roboter sieht die Forscherin von der NTU Singapure derzeit vor allem in der Pflege- und Betreuungsarbeit mit älteren Menschen. Hier wird in wenigen Jahren ein großer Arbeitskräftemangel herrschen. „Soziale Roboter könnten als Begleiter und Unterstützung der Menschen agieren“, meinte Thalmann.

Politik und Gesellschaft sollten jetzt entscheiden, was wir Robotern alles zu tun erlauben wollen. Jetzt ist die richtige Zeit, um darüber zu diskutieren. – Nadia Thalmann

Damit Roboter wirklich sinnvoll eingesetzt werden können, braucht es jedoch geeignete Rahmenbedingungen. Selbst für Roboter muss es Regeln geben, die deren Verhalten steuern: „Auch, wenn Roboter nie wirklich fühlen, sondern Emotionen immer nur simulieren können, müssen wir doch in deren Software Grenzen für ihr Verhalten verankern“, plädierte Thalmann, die ihren Roboter etwa bewusst zur Ehrlichkeit programmiert hat.

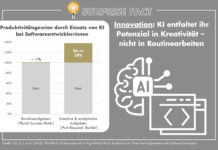

Roboter in der Arbeitswelt

Werden Roboter den Menschen in der Arbeitswelt ersetzen? Roboterforscherin Thalmann sieht dafür in der nächsten Zeit keine Hinweise, auch wenn ihre Tests und Projekte überaus erfolgreich verlaufen: „Nadine kann einige eng definierte Bereiche gut beherrschen, aber sie wird in absehbarer Zeit keinen vollwertigen menschlichen Job übernehmen – nur Teilbereiche“, schilderte Thalmann. Sie verwies darauf, dass wir nur einen Bruchteil der Psychologie und Physiologie des Menschen wirklich verstehen – trotz Jahrhunderten an Forschung. „Von unseren Robotern wissen wir aber alles. Sie sind bei Weitem nicht so komplex wie der Mensch“, so Thalmann.

Generell identifizierte die gebürtige Schweizerin, die jetzt in Singapur lebt, deutliche kulturelle Unterschiede im Umgang mit Robotern in zwischen den USA, Europa und Ostasien. Während Asiaten neuen Technologien gegenüber tendenziell aufgeschlossener sind, agieren Europäer zuerst eher skeptisch und vorsichtig. „Wenn man in Asien feststellt, dass ein Roboter einen Job genauso gut oder besser als ein Mensch machen kann, dann wird man einen Roboter einsetzen. Hier zählt vor allem die Effizienz“, so Thalmann.

Mehr Technologiefolgen-Abschätzung nötig

Die Journalistin Dr. Susanne Gaschke warnte vor „digitaler Verdummung” und forderte intensivere Technologiefolgen-Abschätzung, um die Risiken der Digitalisierung vorhersehen und minimieren zu können: „Wir nutzen die digitalen Möglichkeiten vielfach auch aus reiner Bequemlichkeit, ohne deren negativen Auswirkungen ausreichend zu bedenken: Der Online-Handel etwa, lässt die Innenstädte veröden und erhöht die Verkehrsproblematik. Die gewaltigen Datenmengen erfordern immer höhere Speicherkapazitäten mit entsprechendem Energiebedarf, daraus wird ein höchst unökologisches System”, so Gaschke.

Die Digitalisierung eröffnet für sie auch neue Herausforderungen im Bildungswesen. „Erwachsene und Kinder müssen lernen, wie man zu sinnvollen und richtigen Informationen im Internet kommt.” Gerade die Nachrichtenkommunikation im Internet birgt auch Risiken in sich, meinte die Journalistin: „Extreme Meinungen werden im Netz besonders hoch gewertet und dementsprechend stark verbreitet. Journalisten nutzen heute bewusst diese Logik aus und tragen dadurch zum Erstarken dieser Ideen bei”.

Man muss viel wissen, um viel aus dem Internet rausholen zu können. – Susanne Gaschke

Gerade im Bildungswesen sollte der Einsatz digitaler Technologien wohl bedacht stattfinden, denn neue Studien zeigen, dass Kinder die früh in Kontakt mit „digitalen Ablenkungsmaschinen“ in Kontakt kommen, wesentliche (menschliche) Fähigkeiten zu wenig ausbilden könnten. Trotzdem hat die Digitalisierung auch sehr viele positive Seiten. In Bezug auf fehlende Arbeitskräfte im Pflegebereich meinte Gaschke etwa, dass Roboter als Pflegekräfte immer noch besser seien, als gar keine Betreuung.

Sie plädiert dafür, noch breiter über die negativen und positiven Folgen der technologischen Entwicklung zu diskutieren und findet: „Technologischer Fortschritt gilt heute fast schon als sakrosankt. Darüber darf man nicht öffentlich diskutieren. Das sollte man aber“.

Nicht alles tun, was man kann

Markus Hengstschläger sprach sich in den Diskussionen dafür aus, dass der Mensch nicht alles, was technisch oder wissenschaftlich möglich ist, auch tatsächlich umsetzen sollte. In gewissen Bereichen – dort wo die Risiken nicht abschätzbar sind – muss sorgfältig vorgegangen werden. Der Genetiker verwies als Beispiel für Mögliches, das aber international abgelehnt wurde, auf die vor Kurzem publik gewordenen Fälle von gentechnisch modifizierten Embryos in China. Hier hat sich innerhalb kürzester Zeit die Politik und Wissenschaft weltweit und auch in China selbst, dafür ausgesprochen, derartige Experimente nicht zulassen zu wollen.

„Es liegt auch an der Politik, die technologische Entwicklung so zu entschleunigen, dass der Mensch noch mitkommt“, unterstrich Hengstschläger und betonte, dass es mehr Bemühungen für globale Vereinbarungen zu den großen Herausforderungen vor denen die Menschheit steht, braucht. Alle diese neuen Technologien kann und soll man zum Nutzen der Menschen verwenden, „wir brauchen aber eine permanente ethische Begleitung in der Diskussion technologische Innovationen“, so Hengstschläger. Und die Moderatorin des Symposiums, Melinda Crane fasste zusammen: „Wir können diese neuen Technologien nicht stoppen. Wir müssen und können sie aber gestalten. Um die Risiken zu minimieren und den Nutzen zu maximieren.“

SURPRISE FACTORS PLENUM

Erste Ergebnisse und Einsichten in die Thematik des Symposiums, wurden beim PLENUM mit mehr als 700 Besucher*innen im Kongresszentrum Toscana präsentiert. Alle Videos und Inhalte vom PLENUM >SURPRISE FACTORS REPORT

Die Ergebnisse und Ideen des Symposiums werden in den nächsten Wochen im SURPRISE FACTORS REPORT schriftlich verdichtet. Zu den Reports der letzten Jahre >